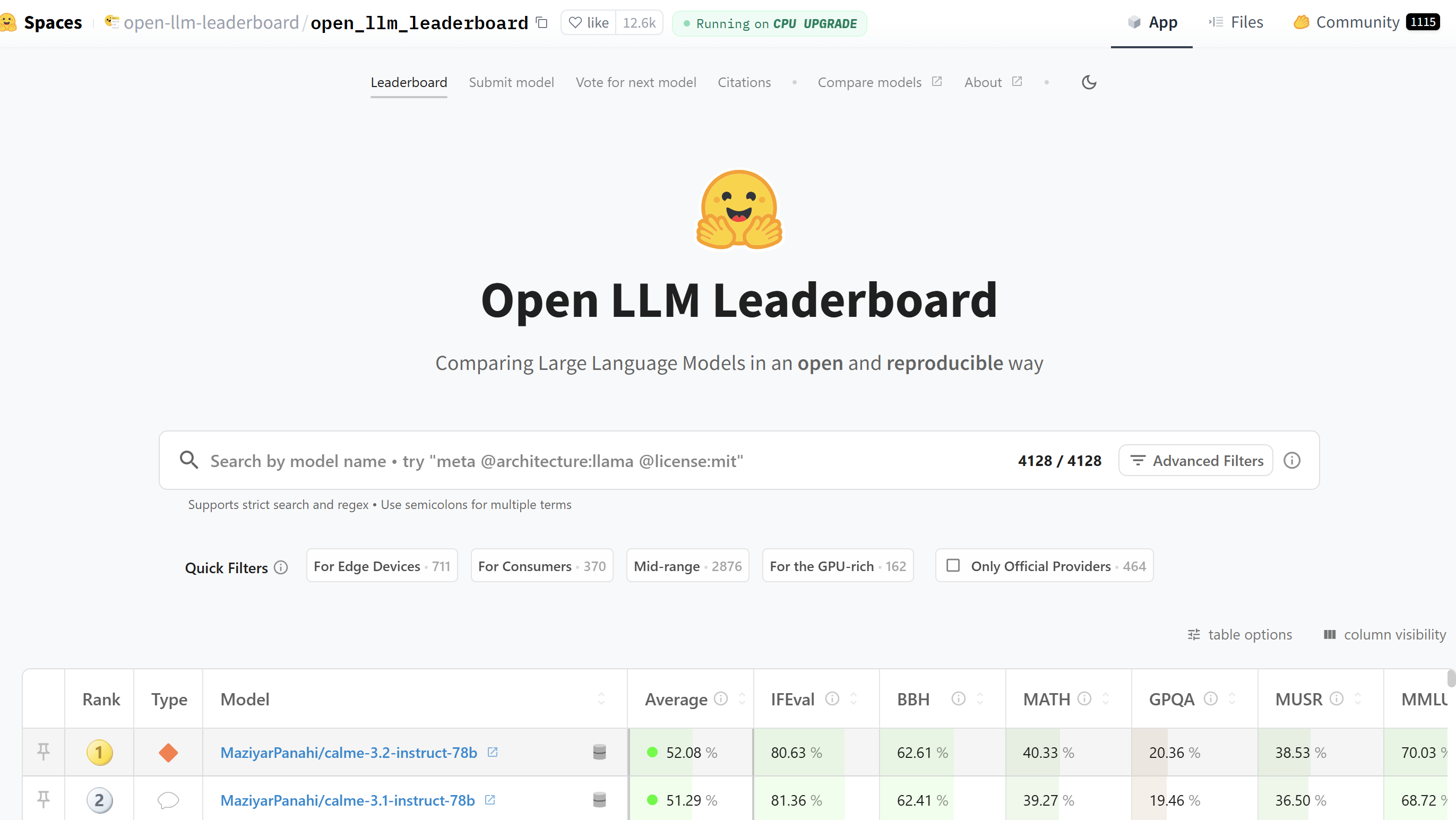

Open LLM Leaderboard 是一个由 Hugging Face 发布的开源大模型排行榜,旨在跟踪、排名和评估开源的大型语言模型(LLMs)。以下是关于 Open LLM Leaderboard 的详细介绍:

一、榜单目的与意义

随着大型语言模型技术的快速发展,市场上涌现出众多模型,其性能各异。为了客观、公正地评估这些模型的能力,帮助开发者选择最适合自己需求的模型,Open LLM Leaderboard 应运而生。该榜单提供了一个统一的评估框架,使得不同模型能够在相同的条件下进行比较,从而为用户提供了有价值的参考信息。

二、评估标准与方法

Open LLM Leaderboard 采用多种基准测试对模型进行评估,包括但不限于:

- MMLU-Pro:MMLU 数据集的改进版本,提供十个选项而不是四个,要求在更多问题上进行推理,并经过专家审查以减少噪音量。

- GPQA:一个极其困难的知识数据集,问题由领域专家(如生物学、物理学、化学等领域的博士)设计,经过多轮验证以确保难度和准确性。

- MuSR:由算法生成的复杂问题组成,要求模型结合推理和非常长的上下文解析能力。

- MATH:包含中高级别竞赛问题的汇编,要求生成的答案必须严格遵循特定的输出格式。

- IFEval:测试模型清晰遵循明确指令的能力。

- BBH:BigBench 数据集中 23 个具有挑战性的任务的子集,包含多步算术和算法推理、语言理解等任务。

这些基准测试涵盖了广泛的能力范围,从逻辑推理到常识应用,再到数学解题能力等,能够全面评估模型的综合性能。

三、榜单特点

- 客观性:Open LLM Leaderboard 采用统一的评估框架和基准测试,确保不同模型在相同的条件下进行比较,评估结果客观公正。

- 实时性:榜单定期更新,及时反映最新模型的性能表现,帮助用户了解大模型技术的最新进展。

- 透明性:评估过程和结果公开透明,用户可以查看每个模型的详细得分和评估细节,增加评估的可信度。

- 多样性:榜单涵盖了多种类型和规模的语言模型,包括基础模型、聊天模型等,满足不同用户的需求。

四、榜单影响与应用

Open LLM Leaderboard 自发布以来,受到了广泛的关注和认可。它不仅为开发者提供了有价值的参考信息,还促进了大模型技术的交流和发展。许多研究机构和企业在选择和使用大模型时,都会参考该榜单的评估结果。

此外,Open LLM Leaderboard 还为模型开发者提供了一个展示自己模型性能的平台。通过参与榜单评估,开发者可以了解自己模型的优势和不足,进而进行有针对性的改进和优化。

五、榜单更新与发展

为了应对大模型技术的不断发展和变化,Open LLM Leaderboard 也在不断更新和完善。例如,推出了新版本(如 Open LLM Leaderboard v2),引入了更具挑战性的基准测试和评估方法,以更准确地反映模型的实际性能。

同时,Hugging Face 还计划在未来继续扩展和优化 Open LLM Leaderboard,增加更多的基准测试和评估维度,以满足不同用户的需求和期望。

六、如何查看榜单

用户可以通过访问 Hugging Face 的官方网站或相关平台,查看 Open LLM Leaderboard 的最新排名和评估结果。在榜单页面上,用户可以查看每个模型的详细得分、评估细节以及与其他模型的比较结果等信息。

总结来看,Open LLM Leaderboard 是一个客观、公正、实时且透明的开源大模型排行榜,为开发者提供了有价值的参考信息,促进了大模型技术的交流和发展。

相关导航

H2oGPT

PubMedQA

MMLU Dataset(大规模多任务语言理解数据集)

SuperCLUE

CMMLU

MMBench