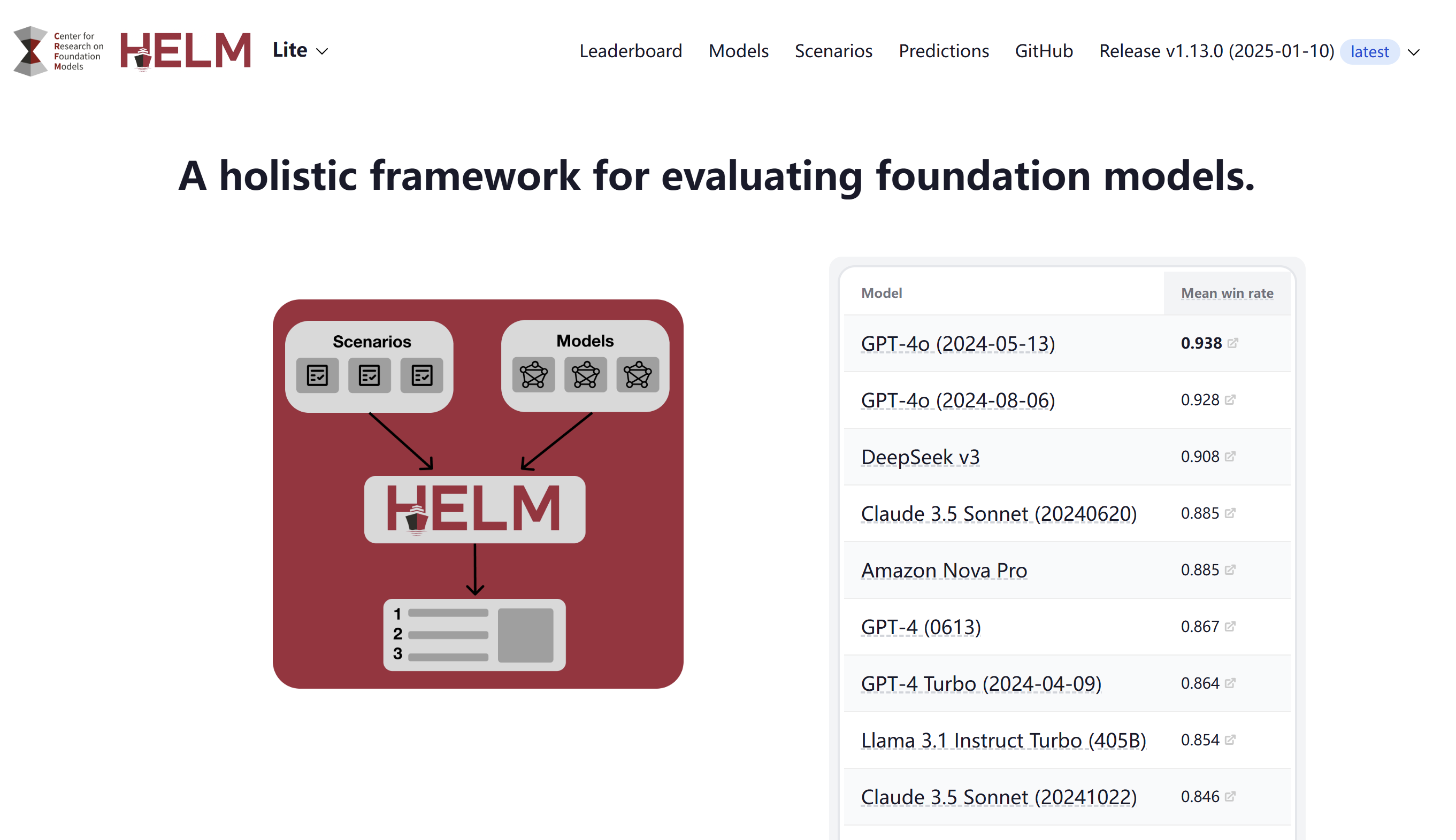

Holistic Evaluation of Language Models(HELM)是一个由斯坦福大学提出的语言模型综合评估框架。以下是关于HELM的详细介绍:

一、背景与目的

随着语言模型在自然语言处理(NLP)领域的广泛应用,对其能力、局限性和风险的理解变得尤为重要。HELM旨在通过全面的评估方法,提高语言模型的透明度,帮助开发者、研究人员和公众更好地了解语言模型在不同场景下的表现。

二、评估方法

HELM采用了一种综合的评估方法,主要包括以下几个方面:

-

场景分类:

- HELM对语言模型感兴趣的潜在应用场景(即用例)进行了广泛的分类。这些场景涵盖了多个任务、领域和语言,以确保评估的全面性。

-

多指标衡量:

- 除了准确性外,HELM还考虑了其他多个指标,如校准性、鲁棒性、公平性、偏见、毒性和效率等。这些指标共同构成了对语言模型性能的全面评估。

-

标准化评估:

- 为了确保不同语言模型之间比较的有意义性,HELM控制了语言模型迁移到不同场景的策略,并在相同的场景下对模型进行评估。

三、核心场景与指标

HELM实现了一组核心的评估场景和指标:

-

核心场景:

- HELM包含16个核心场景,这些场景由任务、领域和语言的三元组表示。例如,问题回答、信息检索、内容总结等任务,在新闻、图书等领域,以及英语(包括其方言变种)等语言上进行评估。

-

核心指标:

- HELM的7类核心指标反映了一系列社会学原则,包括准确性、校准性、鲁棒性、公平性、偏见、毒性和效率等。

四、额外场景与评估

除了核心场景外,HELM还在26个额外场景上进行了有针对性的评估。这些额外场景涵盖了语义理解、世界和常识知识、推理能力、记忆和版权、虚假信息生成、偏见和有害信息生成等方面,提供了比核心场景更深入的讨论。

五、评估结果与影响

HELM对30个突出的语言模型(跨越开放、有限访问和封闭模型)进行了大规模评估。这些模型在42个场景中的表现被详细记录和分析。HELM的评估结果不仅帮助开发者了解模型的优势和不足,还推动了NLP领域的技术进步和模型改进。

六、公开透明

HELM的评估过程和结果都是公开透明的。所有原始模型提示和完成都被公开发布,以供进一步分析。此外,HELM还提供了一个通用的模块化工具包,方便其他研究者和开发者进行类似的评估。

七、意义与未来

HELM作为语言模型综合评估的框架,具有重要的学术意义和实际应用价值。它不仅提高了语言模型的透明度,还促进了NLP领域的技术进步和模型改进。未来,随着语言模型的不断发展和应用场景的不断拓展,HELM也将继续更新和完善其评估方法和指标,以更好地适应新的需求和挑战。

总结来看,HELM是一个全面、科学、客观的语言模型综合评估框架,它通过广泛的场景分类、多指标衡量和标准化评估方法,为语言模型的性能评估提供了有力的支持。

相关导航

Open LLM Leaderboard

SuperCLUE

MMBench

斯坦福大学

斯坦福大学(Stanford University)

Chatbot Arena